流式十年 从初识Flink看数据处理与存储的演进之路

初识Flink:流处理的集大成者

Apache Flink,作为当前流处理领域的明星框架,自2014年进入Apache孵化器以来,以其高吞吐、低延迟、精确一次(Exactly-Once)的语义保证和强大的状态管理能力,迅速成为大数据实时计算的首选引擎之一。Flink的核心设计理念是“万物皆流”,它将批处理视为有界流(Bounded Stream)的特例,真正统一了流批处理的计算模型。对于初学者而言,理解Flink的窗口(Window)、状态(State)、时间(Event Time/Processing Time)和检查点(Checkpoint)机制,是叩开现代流处理世界大门的关键钥匙。

Flink的出现并非偶然,它站在了近十年来流式处理技术演进浪潮的浪尖之上。它的成功,是数据处理范式、计算架构和存储服务共同演进、相互作用的必然结果。

近十年流式处理的三大演进主线

过去十年,流式数据处理领域经历了翻天覆地的变化,其演进主要围绕三条主线展开:

1. 计算范式的演进:从“微批”到“真流式”

十年前,以Apache Storm为代表的第一代流处理框架,虽然实现了低延迟,但在吞吐量、容错性和状态管理上存在短板。以Spark Streaming为代表的“微批处理”(Micro-Batching)范式兴起,通过将连续的数据流切割成微小的时间批次(如1秒),复用成熟的批处理引擎(如Spark Core)进行计算。这种方式在吞吐和容错上取得了平衡,但其本质仍是批处理,延迟通常在秒级,且难以处理基于事件时间的复杂窗口(如会话窗口)。

以Apache Flink和后来改进的Apache Storm(Trident)为代表的第三代“真流式”处理框架,彻底抛弃了微批的概念,实现了逐条记录的持续处理,将延迟降低到毫秒级,同时通过分布式快照(如Flink的Chandy-Lamport算法)等技术,在低延迟下依然保证了强大的容错性和精确一次语义。这标志着流处理从“快速批处理”走向了原生、成熟的“数据流”计算。

2. 架构的演进:从Lambda到Kappa

数据处理架构也发生了深刻变革。十年前流行的Lambda架构,要求同时维护批处理层(处理全量历史数据,保证准确性)和速度层(处理实时数据,保证低延迟),两套代码、两套系统,复杂度高,维护困难。

随着以Flink为代表的强大流处理引擎成熟,Kappa架构被提出并逐渐成为主流。Kappa架构主张只保留流处理层,通过流来统一处理所有数据:实时数据直接处理,历史数据则通过重放(Replay)日志流(如Kafka)到流处理引擎中进行回溯计算。这大大简化了系统架构,降低了开发和运维成本。Flink完善的状态管理和事件时间支持,正是实现Kappa架构的理想基石。

3. 存储与服务的演进:从分离到统一与云原生

流处理离不开存储的支撑,存储服务的演进同样是关键驱动力。

- 消息队列/日志系统的核心化:Apache Kafka的崛起具有里程碑意义。它不再仅仅是消息队列,更是可持久化、高吞吐、支持回溯的分布式事件日志系统(Log),成为了流处理事实上的“数据脊柱”。流处理系统从Kafka消费数据,并将结果写回Kafka,形成了清晰的数据流管道。

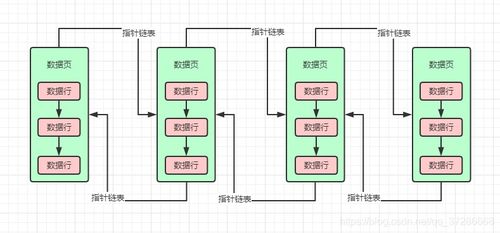

- 状态存储的外化与专业化:早期流处理框架的状态常驻于内存或本地磁盘,容量和可靠性受限。如今,Flink等框架支持将状态后端(State Backend)外置到RocksDB(本地KV存储)、Apache Cassandra或云数据库等,实现了海量状态的高效、可靠管理。流处理与OLAP的融合,使得处理结果可以直接写入ClickHouse、Druid等实时分析数据库,供即时查询。

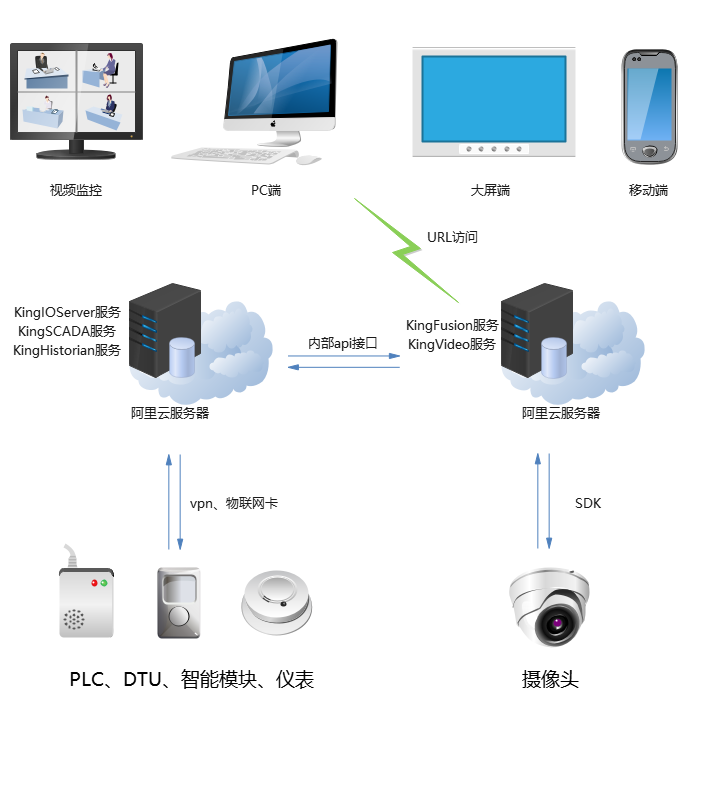

- 云原生与存储计算分离:近五年,云原生成为趋势。以Apache Pulsar(云原生消息流平台)、Pravega(为流而生)为代表的存储系统,以及Flink on K8s的部署模式,都体现了存储与计算资源解耦、弹性伸缩、按需使用的思想。对象存储(如S3)也开始通过Apache Iceberg、Delta Lake等表格格式,支持流式数据的实时入湖,实现流批一体的数据湖存储。

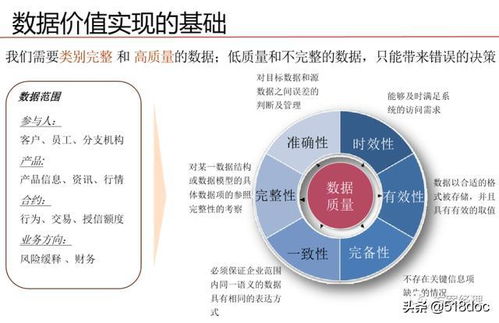

数据处理与存储服务的未来展望

回顾这十年,流式处理已经从一项前沿技术,发展成为支撑实时推荐、风控监控、物联网分析等核心业务的基石。以Flink为中心的现代流式技术栈,正朝着以下方向发展:

- 流批一体与数据湖仓融合:以Flink + Iceberg/Hudi为代表的方案,正推动流式数据直接进入数据湖,并在湖内进行高效的批处理与分析,模糊了数据仓库与数据湖、流与批的边界。

- 实时数仓与HTAP:流处理正成为构建实时数据仓库的核心组件,并与OLAP数据库深度结合,向混合事务/分析处理(HTAP)演进,满足对数据“既快又准”的复杂需求。

- AI与流处理的结合:流式机器学习(Streaming ML)正在兴起,模型可以在数据流上实时训练、更新与推理,让AI系统能够动态响应瞬息万变的数据。

##

初识Flink,是理解这个流式处理黄金时代的一个绝佳切入点。它不仅是技术演进的产物,更是推动新一轮变革的引擎。从微批到真流,从Lambda到Kappa,从孤立系统到以日志流为核心的统一生态,数据处理与存储服务在过去十年共同编织了一张实时、智能、弹性的大数据网络。对于开发者和架构师而言,掌握以Flink为代表的现代流处理思想与技术栈,已然是面向未来数据世界的必备能力。流式十年,方兴未艾,实时智能的未来正由此刻的数据流所定义。

如若转载,请注明出处:http://www.ghostplans.com/product/39.html

更新时间:2026-02-24 00:15:09